Korrelation und Kausalität sind 2 Paar Schuhe

Algorithmen haben keinen gesunden Menschenverstand

Es gibt ein wichtiges Merkmal von Algorithmen, das man beim Thema Machine Learning und Predictive Analytics nicht aus den Augen verlieren darf: Algorithmen können noch so leistungsstark sein, sie haben aber keinen gesunden Menschenverstand. Trotz des Hype um die vielen, potenziell nutzbringenden Anwendungen von Machine Learning sollte klar sein, dass Predictive Analytics nichts macht, was ein Analytiker mit einer Tabellenkalkulation nicht auch erreichen könnte – wenn er dafür nur genügend Zeit hätte.

Zudem braucht es gesunden Menschenverstand, um Daten korrekt zu interpretieren. Wir neigen oft zu einer Überbewertung von Erfolgen und dem selektiven Ausblenden von Misserfolgen. Die Wissenschaft hat dafür den Begriff „Survivorship Bias“ geprägt. Dieses Phänomen spielt auch bei allen Spielarten von Analytics und Machine-Learning-Anwendungen eine Rolle.

Auf die Interpretation kommt es an

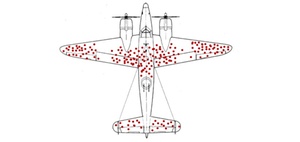

Die Entdeckung des Phänomens des Survivorship Bias geht auf die Luftschlacht um England im Zweiten Weltkrieg zurück. Englische Ingenieure studierten die Einschusslöcher der aus dem Einsatz zurückkommenden Flugzeuge. Ihnen fiel auf, dass bestimmte Stellen sehr häufig getroffen wurden (s. Abb.). Die vermeintlich schlaue Lösung der Ingenieure bestand darin, diese Stellen durch Panzerung zu verstärken. Ein Erfolg blieb jedoch aus, es kamen nicht mehr Flugzeuge zurück als bisher.

Der ungarische Mathematiker Abraham Wald fand schließlich heraus, dass der Erfolg größer ist, wenn man die Stellen besser schützt, die keine Einschusslöcher aufweisen. Schließlich waren die zurückkehrenden Flugzeuge ja der beste Beleg dafür, dass die Stellen mit Einschusslöchern nicht problematisch für die Rückkehr waren. Treffer an den anderen Stellen hingegen waren offensichtlich fatal, denn Maschinen mit solchen Treffern kehrten gar nicht erst zurück.

Kausalität vs. Korrelation

Die Lektion aus dieser Geschichte ist also, dass Machine Learning und die Anwendung von Algorithmen keinesfalls die gründliche Analyse der Ergebnisse und die kritische Überprüfung der Modelle an der Realität ersetzen können.

Der Philosoph Byung-Chul Han bringt das Big-Data-Dilemma auf den Punkt:

Selbst die größte Ansammlung von Informationen, Big Data, verfügt über sehr wenig Wissen. Anhand von Big Data werden Korrelationen ermittelt. Die Korrelation besagt: Wenn A stattfindet, so findet oft auch B statt. Warum es so ist, weiß man aber nicht. Die Korrelation ist die primitivste Wissensform, die nicht einmal in der Lage ist, das Kausalverhältnis, d. h. das Verhältnis von Ursache und Wirkung, zu ermitteln. Es ist so. Die Frage nach dem Warum erübrigt sich hier. Es wird also nichts begriffen. Wissen ist aber Begreifen. So macht Big Data das Denken überflüssig. Wir überlassen uns bedenkenlos dem Es-Ist-so.

(Han, Im Schwarm. Ansichten des Digitalen, 2013)

Dies sollte man immer beim Einsatz von automatischen und selbstlernenden Algorithmen berücksichtigen.

Entnommen aus: Nagel, Matthias/Riedel, Ralph/Nagel, Matthes; "Predictive Maintenance: Zukunftsweisender Ansatz für mehr Effektivität und Effizienz in der Instandhaltung", in Klein, Modernes Produktionscontrolling für die Industrie 4.0, 2018.

-

So führen Sie mehrere Excel-Tabellenblätter in einer Pivot-Tabelle zusammen

540

-

Diagramme mit gestapelten Säulen erstellen

387

-

Mit der Formel SUMME über mehrere Excel-Tabellenblätter schnell und einfach Werte addieren

358

-

Mit der Formel INDIREKT dynamische Zellen- und Bereichsbezüge erstellen

302

-

Mit den Formeln LÄNGE, LINKS, RECHTS Textbausteine aus Zellen extrahieren

271

-

Datumswerte in Pivot-Tabellen mithilfe einer Gruppierung zusammenfassen

233

-

EXCEL-TIPP: Mittelwert ohne Null ermitteln

185

-

Nur sichtbare Zellen in Excel auswählen

174

-

Wie Sie Datumsangaben in einer Pivot-Tabelle zum Filtern nutzen

141

-

Veraltete Werte aus den Filtern einer Pivot-Tabelle löschen

137

-

Wer hat Interesse an Beratung von internationalen Controlling-Experten? Und das honorarfrei!

26.02.2026

-

BI-Implementierung bei Georg Fischer: Von fragmentierter Planung zur integrierten Management-Suite

25.02.2026

-

Die neue Agenda der CFOs: Zwischen Risikoabwehr und Transformation

23.02.2026

-

Strategische Planung bei Uniper: von Excel zu SAC

19.02.2026

-

Transformation braucht Steuerung – und Controlling wird zur Erfolgsvoraussetzung

18.02.2026

-

Abwärtstrend im Finance-Arbeitsmarkt setzt sich fort – nur zwei Positionen im Plus

11.02.2026

-

7 Fehler, die jede BI-Einführung scheitern lassen

10.02.2026

-

Congress der Controller: Prepared for uncertainty - Strategien und Lösungsbeispiele (27./28.04.2026)

09.02.2026

-

Microsoft Copilot im Controlling: Assistenz oder Revolution?

05.02.2026

-

Der ICV trauert um Siegfried Gänßlen

04.02.2026